Die Anfänge und Entwicklung der Künstlichen Intelligenz

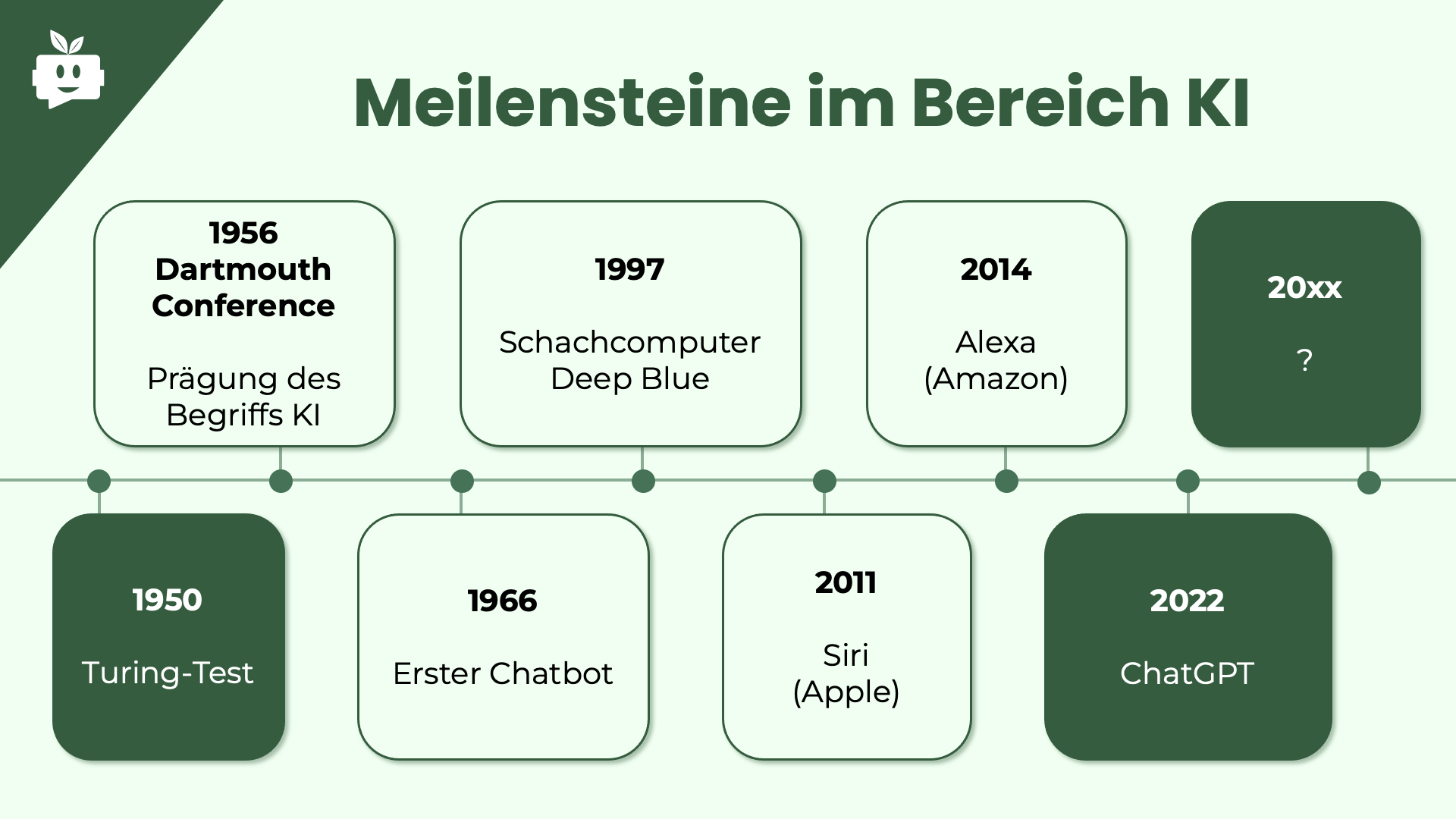

Die „Dartmouth Conference“ im Jahr 1956 gilt oft als der formelle Startpunkt der KI-Forschung und griff dabei auf die visionären Ideen von Alan Turing zurück, der bereits in den 1950er Jahren die Grundlagen für maschinelles Denken gelegt hatte. In seinem berühmten Artikel „Computing Machinery and Intelligence“ (1950) führte Turing den Turing-Test (Turing-complete) ein, der bis heute als Maßstab dafür dient, ob eine Maschine „denken“ kann.

Seitdem hat die KI-Entwicklung eine bemerkenswerte Reise zurückgelegt. Ein entscheidender Moment war 1997, als der IBM-Computer Deep Blue den Schachweltmeister Garry Kasparov besiegte – ein Ereignis, das weltweit für Aufsehen sorgte und den Leistungsstand der KI beeindruckend demonstrierte. 2016 gelang ein weiterer Meilenstein: Googles AlphaGo besiegte den weltbesten Go-Spieler Lee Sedol, was aufgrund der enormen Komplexität des Go-Spiels als nahezu unmöglich galt. Im Vergleich zu Schach ist Go deutlich komplexer, da es viel mehr mögliche Spielzüge und Kombinationen hat. Bemerkenswerterweise entwickelte sich AlphaGo weiter, und seine nachfolgende Version, AlphaGo Zero, besiegte schließlich das ursprüngliche AlphaGo, ohne jemals menschliche Spielzüge gesehen zu haben – es brachte sich das Spiel durch Selbstlernen bei.

Parallel dazu hielt KI immer mehr Einzug in unseren Alltag. Sprachassistenten wie Apples Siri (2011) und Amazons Alexa (2014) machten KI für Millionen von Menschen zugänglich und erleichterten zahlreiche Aufgaben im täglichen Leben. Schließlich wurde 2022 mit dem Aufkommen von OpenAIs GPT-Sprachmodellen ein weiterer bedeutender Schritt erreicht, der das Potenzial von KI im Umgang mit Sprache eindrucksvoll unter Beweis stellte und eine regelrechte Welle der Euphorie auslöste.

Doch was steckt eigentlich hinter dieser faszinierenden Technologie, und wie funktioniert KI eigentlich?

Wie funktioniert Künstliche Intelligenz?

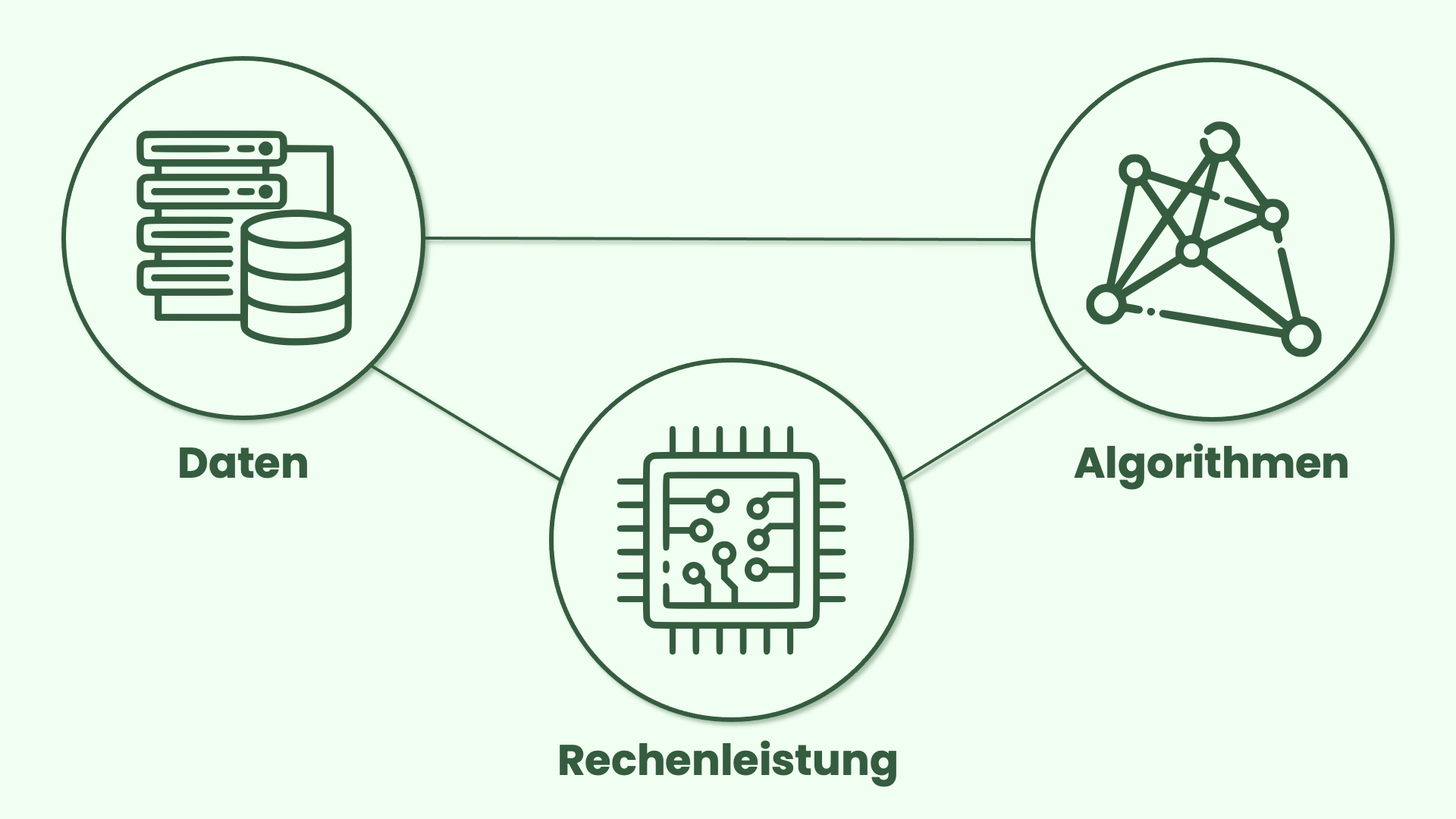

Künstliche Intelligenz bezeichnet die Fähigkeit von Maschinen und Computersystemen, menschenähnliche Intelligenz zu simulieren, um Aufgaben autonom oder semi-autonom zu erledigen und dabei kontinuierlich aus ihren Erfahrungen zu lernen und sich an neue Eingangssignale anzupassen. Diese Systeme basieren auf großen Datenmengen, erheblicher Rechenleistung und spezialisierten Algorithmen.

- Große Datenmengen: KI-Systeme benötigen Zugang zu umfangreichen und vielfältigen Datensätzen, um Muster zu erkennen und Vorhersagen zu treffen. Diese Daten stammen aus verschiedenen Quellen, wie sozialen Medien, Sensoren oder Online-Plattformen. Um die Leistungsfähigkeit von KI-Systemen zu maximieren, werden große Datenmengen durch den Einsatz von Big Data-Technologien gesammelt und verarbeitet. Diese Technologien ermöglichen es, Daten in Echtzeit zu erfassen, zu speichern und zu analysieren. Dadurch können Muster und Trends identifiziert werden, die dann als Grundlage für präzisere Vorhersagen und fundierte Entscheidungen dienen. Je größer und qualitativ hochwertiger der Datensatz ist, desto besser kann das KI-Modell lernen und agieren.

- Erhebliche Rechenleistung: Die Verarbeitung dieser riesigen Datenmengen erfordert enorm viel Rechenleistung. Fortschritte in der Hardware, wie die Entwicklung spezialisierter Prozessoren (z.B. GPUs), ermöglichen es KI-Systemen, komplexe Berechnungen schnell durchzuführen. Diese spezialisierten Prozessoren sind darauf ausgelegt, große Mengen an Daten parallel zu verarbeiten, was bedeutet, dass sie viele Berechnungen gleichzeitig durchführen können. Dadurch können KI-Modelle schneller trainiert und Echtzeitanalysen effizienter durchgeführt werden. Diese Fortschritte sind entscheidend, um wertvolle Erkenntnisse aus den gesammelten Daten zu gewinnen und KI-Anwendungen effektiver zu gestalten.

- Spezialisierte Algorithmen: Um aus den gesammelten Daten sinnvolle Erkenntnisse zu gewinnen, kommen spezialisierte Algorithmen zum Einsatz. Diese Algorithmen sind darauf ausgelegt, spezifische Aufgaben zu bewältigen, wie das Erkennen von Bildern oder das Verstehen von Sprache. Sie analysieren die Daten und suchen nach Mustern, die ihnen helfen, diese Aufgaben zu erfüllen. Zum Beispiel können Algorithmen, die für die Bildverarbeitung entwickelt wurden, bestimmte Merkmale in Bildern identifizieren, um zu erkennen, ob es sich um ein Tier oder einen Gegenstand handelt. Bei Sprachverarbeitungsalgorithmen wird die Reihenfolge der Wörter betrachtet, um den Kontext und die Bedeutung besser zu verstehen. Mit fortschreitender Forschung werden diese Algorithmen ständig verbessert, was zu immer leistungsfähigeren KI-Anwendungen führt.

Diese drei Elemente sind entscheidend für die Entwicklung effizienter und präziser KI-Anwendungen, die in einer Vielzahl von Bereichen transformative Veränderungen herbeiführen. Doch welche Unternehmen stecken eigentlich dahinter?

Key Player

- Erhebliche Rechenleistung: Die Rechenleistung ist das Herzstück der KI, und hier dominiert vor allem Nvidia den Markt. Nvidia hat sich von einem Hersteller von Grafikprozessoren (GPUs) zu einem unverzichtbaren Akteur in der KI-Industrie entwickelt. Nvidias Alleinstellungsmerkmal liegt in der Fähigkeit der GPUs, massives paralleles Rechnen zu ermöglichen – eine wesentliche Voraussetzung für das Training großer KI-Modelle. Nvidia kann auch als bestes Beispiel für den immensen KI-Aufschwung gesehen werden, der seit der Einführung von ChatGPT begonnen hat. So hat sich der Gesamtumsatz von 2022 bis 2024 auf über 60 Mrd. USD mehr als verdoppelt. Ein wichtiger Partner in diesem Zusammenhang ist TSMC (Taiwan Semiconductor Manufacturing Company), der weltweit führende Auftragsfertiger für Halbleiter. TSMC produziert die hochentwickelten Chips, die in den Nvidia-GPUs verbaut werden. Diese Zusammenarbeit ist entscheidend, da TSMC die fortschrittlichsten Fertigungstechnologien zur Verfügung stellt, die es Nvidia ermöglichen, leistungsfähigere und effizientere Chips herzustellen.

- Große Datenmengen: Daten sind der Treibstoff der Künstlichen Intelligenz, und einige der größten Unternehmen der Welt haben Zugang zu gewaltigen Datenmengen. Google beispielsweise sammelt täglich enorme Mengen an Daten über seine Suchmaschine, YouTube, Maps und andere Dienste. Auch Meta und Amazon verfügen über riesige Datenpools, die durch ihre Plattformen, Nutzerinteraktionen und Online-Transaktionen entstehen.Ein entscheidender Faktor für den Zugang zu großen Datenmengen ist die Cloud-Infrastruktur, die von Anbietern wie Amazon (AWS), Google (Google Cloud) und Microsoft (Azure) bereitgestellt wird. Diese Cloud-Plattformen ermöglichen nicht nur die Speicherung riesiger Datenmengen, sondern auch die schnelle Verarbeitung und Analyse dieser Daten. Sie bieten Unternehmen eine skalierbare und flexible Möglichkeit, auf Daten in Echtzeit zuzugreifen und KI-Modelle effizient zu trainieren. Durch die Cloud wird die Nutzung großer Datenmengen für KI-Unternehmen deutlich zugänglicher und effektiver, was die Entwicklung und den Einsatz von KI-Lösungen enorm beschleunigt.

- Spezialisierte Algorithmen: Spezialisierte Algorithmen sind der Schlüssel, der KI-Systemen ihre Intelligenz verleiht, indem sie es ermöglichen, Muster zu erkennen, Sprache zu verstehen und eigenständig Entscheidungen zu treffen. Unternehmen wie Google und OpenAI sind führend in der Entwicklung dieser Algorithmen und haben mit AlphaGo und Gemini bzw. den GPT-Modellen gezeigt, welches Potenzial in modernen KI-Ansätzen steckt. Auch andere große Player wollen in diesem Bereich mitmischen. So hat Meta das Modell LLaMA entwickelt, während X das eigene Modell Grok auf den Markt gebracht hat. Microsoft, das bereits mit OpenAI kooperiert, integriert die GPT-Modelle in seine Dienste, während Anthropic mit dem Claude-Modell eine vielversprechende Alternative entwickelt hat. Diese Vielfalt zeigt, dass die Entwicklung spezialisierter Algorithmen ein Wettlauf ist, bei dem jeder große Technologieanbieter mitspielen möchte.Ein entscheidender Vorteil dieser Unternehmen liegt in ihrer Fähigkeit, fortschrittliche Algorithmen mit enormen Datenmengen und Rechenleistung zu kombinieren, was es ihnen ermöglicht, KI-Systeme zu entwickeln, die in verschiedenen Bereichen beeindruckende Leistungen erbringen. Dabei setzen sie auf selbstlernende Modelle, die aus Erfahrungen lernen und sich kontinuierlich verbessern können.

Herausforderungen und Chancen

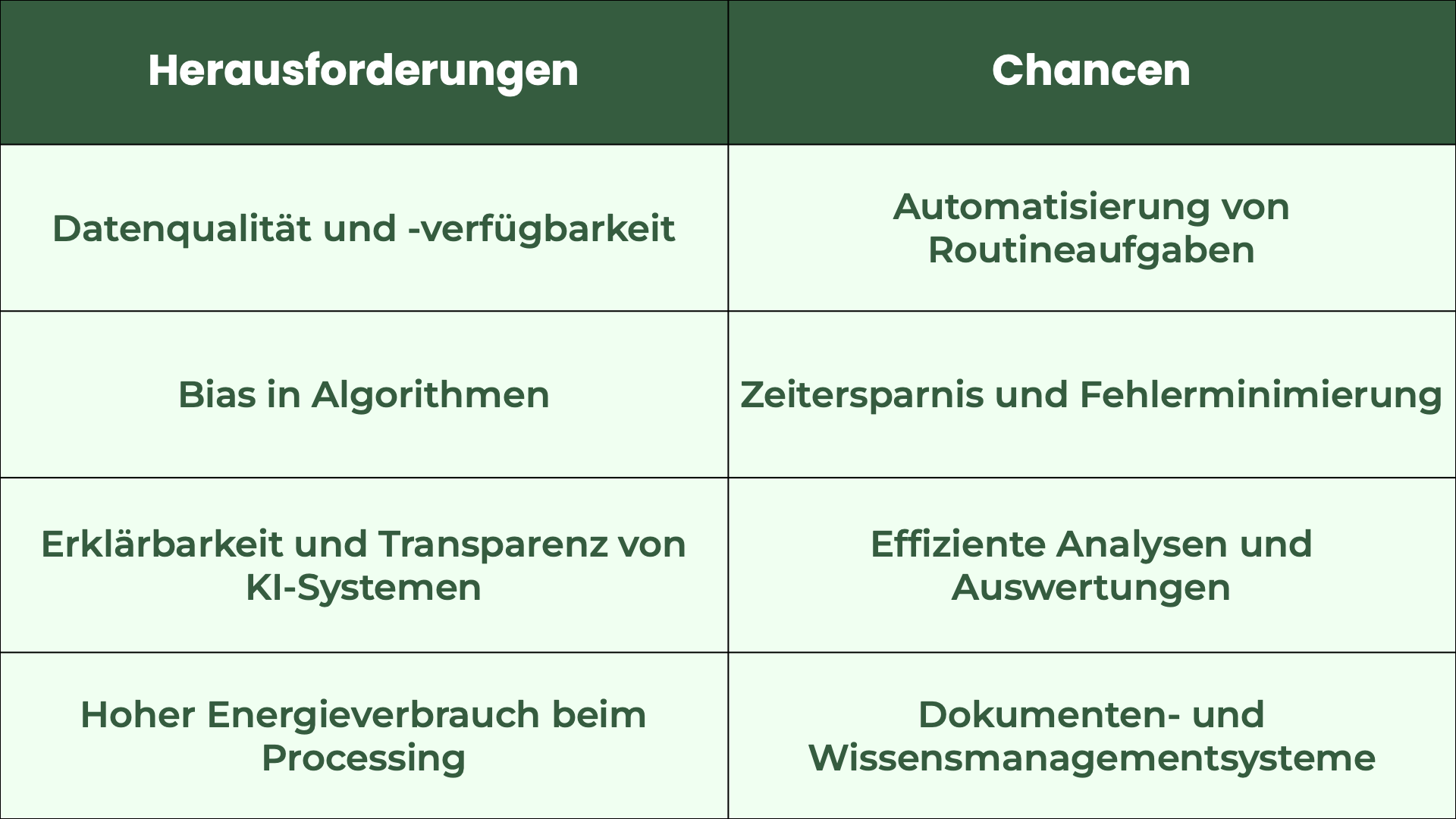

Trotz der beeindruckenden Fortschritte und der breiten Anwendungsmöglichkeiten bringt die Entwicklung und Implementierung von Künstlicher Intelligenz (KI) auch bedeutende Herausforderungen mit sich. Während Unternehmen und Gesellschaften von den Vorteilen dieser Technologien profitieren können, müssen sie gleichzeitig mit den Risiken und Schwierigkeiten umgehen, die mit der Nutzung von KI verbunden sind.

Herausforderungen

Eine der zentralen Herausforderungen bei der Implementierung von KI ist die Datenqualität und -verfügbarkeit. Um effektive KI-Modelle zu entwickeln, sind umfangreiche und qualitativ hochwertige Datensätze erforderlich, da mangelnde Datenqualität zu fehlerhaften Vorhersagen und Entscheidungen führen kann. Nutzer sollten auch weiterhin kritisch hinterfragen, aus welchen Quellen die bereitgestellten Informationen stammen, da das Wissen von KI-Systemen nicht immer fehlerfrei ist.

Ein weiteres Risiko ist der Bias in Algorithmen. Wenn die verwendeten Daten voreingenommen sind, kann dies zu diskriminierenden Ergebnissen führen, was in den letzten Jahren zu intensiven ethischen Diskussionen über KI geführt hat, insbesondere da führende Sprachmodelle größtenteils von westlichen Unternehmen entwickelt werden. Die Erklärbarkeit und Transparenz von KI-Systemen stellt ein weiteres Problem dar, da viele moderne Modelle als "Black Boxes" gelten, deren Entscheidungsprozesse oft nur schwer nachvollziehbar sind.

Schließlich ist auch der hohe Energieverbrauch beim Processing von KI-Modellen eine erhebliche Herausforderung. Das Training und die Ausführung komplexer Algorithmen erfordern beträchtliche Rechenressourcen, was zu einer erheblichen Umweltbelastung führt. Innovative Ansätze zur Energieeffizienz sind daher entscheidend, um die Nachhaltigkeit von KI-Systemen zu gewährleisten und ihre Akzeptanz in verschiedenen Branchen zu fördern.

Chancen

Trotz der Herausforderungen bietet KI bedeutende Chancen. Die Automatisierung von Routineaufgaben durch KI ermöglicht es Unternehmen, Arbeitsabläufe zu optimieren und die Effizienz erheblich zu steigern. KI-gestützte Systeme optimieren zeitaufwändige Prozesse, sparen Zeit und reduzieren das Risiko menschlicher Fehler.

Ein bedeutender Bereich, in dem KI Vorteile bieten kann, ist das Dokumentenmanagement. Hier können KI-Technologien die automatisierte Erfassung, Klassifizierung und Analyse von Dokumenten übernehmen, wodurch Unternehmen ihre Verwaltungsprozesse deutlich effizienter gestalten können. Intelligente Systeme sind in der Lage, relevante Informationen aus Verträgen, Berichten und anderen Dokumenten zu extrahieren und diese aufzubereiten..

Zudem kann KI als digitaler Assistent fungieren, der bei Fragen und Informationsbedarf zur Seite steht. Solche intelligenten Bots können in Wissensmanagement-Systeme integriert werden, um Mitarbeitern in Echtzeit Unterstützung zu bieten. Sie ermöglichen den schnellen Zugriff auf relevante Daten und Antworten auf häufig gestellte Fragen, was die Effizienz im Arbeitsalltag erheblich steigert. Durch natürliche Sprachverarbeitung können diese digitalen Assistenten in einer für den Nutzer intuitiven Art und Weise kommunizieren und bieten so eine benutzerfreundliche Schnittstelle zu komplexen Informationssystemen.

Fazit

Rückblickend auf die Entwicklung der Künstlichen Intelligenz wird deutlich, dass viele der bedeutendsten Innovationen erst in den letzten Jahrzehnten realisiert wurden. Dies verdeutlicht das rasante Tempo der technologischen Entwicklung im KI-Bereich. Wenn man beispielsweise bedenkt, dass die ersten Smartphones erst 2007 auf den Markt kamen, wird die Dynamik der Veränderungen, die unsere heutige Zeit prägen, umso deutlicher. Wenn man einen Moment inne hält, kommt man unweigerlich zu der Frage: Wo werden wir in 20 oder 50 Jahren stehen?

Insgesamt stehen wir noch am Anfang einer aufregenden Ära, deren Verlauf noch sehr ungewiss ist. Sicher ist jedoch, dass Künstliche Intelligenz eine zentrale Rolle spielen wird. Mit ihrer Fähigkeit, Routineaufgaben zu automatisieren und komplexe Prozesse zu optimieren, hat KI das Potenzial, sowohl Unternehmen als auch den Alltag der Menschen erheblich zu transformieren. Um dieses Potenzial voll auszuschöpfen, ist es jedoch entscheidend, die technologischen Fortschritte in Einklang mit ethischen Überlegungen zu bringen. Nur durch einen solchen ganzheitlichen Ansatz kann das Vertrauen in KI gestärkt und ihre Entwicklung auf verantwortungsbewusste und nachhaltige Weise gestaltet werden.

Quellen

- Webb, A. (2019). The Big Nine: How the Tech Titans and Their Thinking Machines Could Warp Humanity. PublicAffairs.

- Russell, S., & Norvig, P. (2021). Artificial intelligence: A modern approach (4th ed.). Pearson.

- Stone, P., Brooks, R., Brynjolfsson, E., Calo, R., Etzioni, O., Hager, G., ... & Shoham, Y. (2016). Artificial intelligence and life in 2030. One Hundred Year Study on Artificial Intelligence: Report of the 2015-2016 Study Panel. Stanford University.

- Bishop, C. M. (2006). Pattern recognition and machine learning. Springer.

- Khan, S., & Yurtsever, E. (2021). The role of algorithms in machine learning. International Journal of Computer Applications, 175(28), 1-6.

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep learning. MIT Press.

- Naughton, J. (2018). The Big Four: The fight for the future of the Internet. The Observer.

- Reuters. (2024, August 23). Nvidia's earnings and the rise of AI. https://www.reuters.com/technology/nvidia-earnings-ai-boom-2024-08-23/

- Bloomberg. (2023, November 21). Why TSMC is crucial for Nvidia. https://www.bloomberg.com/news/articles/2023-11-21/why-tsmc-is-crucial-for-nvidia

- Silver, D., Huang, A., Maddison, C. J., Guez, A., Lanctot, M., & Stepney, S. (2016). Mastering the game of Go with deep neural networks and tree search. Nature, 529(7587), 484-489. https://doi.org/10.1038/nature16961

- OpenAI. (2023). ChatGPT: A new era of conversational AI. https://openai.com/research/chatgpt

- Statista. (2024). NVIDIA’s revenue worldwide from 2010 to 2024 (in million U.S. dollars). https://www.statista.com/statistics/988030/nvidia-revenue-worldwide/

- Zhou, Y., & Chen, Y. (2021). Understanding the challenges of artificial intelligence: A comprehensive review. Artificial Intelligence Review, 54(1), 1-36.

- Carvalho, T. P., & Silva, F. J. (2021). Document management systems and artificial intelligence: A review. International Journal of Information Management, 58, 102-115.

- Bertolotti, T., & Sessa, M. (2022). Digital assistants: Challenges and opportunities for knowledge management. Journal of Knowledge Management, 26(4), 930-944.

- Brynjolfsson, E., & McAfee, A. (2014). The second machine age: Work, progress, and prosperity in a time of brilliant technologies. W. W. Norton & Company.