Stellen wir uns folgendes Szenario vor: Wir stellen eine Frage zweimal an ein Sprachmodell. Das Ergebnis: Zwei Antworten, die unterschiedlicher kaum sein könnten. Der Grund? Nicht das Modell, sondern die Art und Weise, wie die Anfrage formuliert ist.

Prompt: „Was sind die ESG-Risiken für ein Immobilienportfolio?“

Antwort von ChatGPT:

„ESG-Risiken für ein Immobilienportfolio betreffen vor allem die Bereiche Umwelt, Soziales und Governance und sind zunehmend ein wichtiger Bestandteil des Risikomanagements von Immobilienunternehmen und Investoren.“

Jetzt derselbe Prompt – leicht verändert:

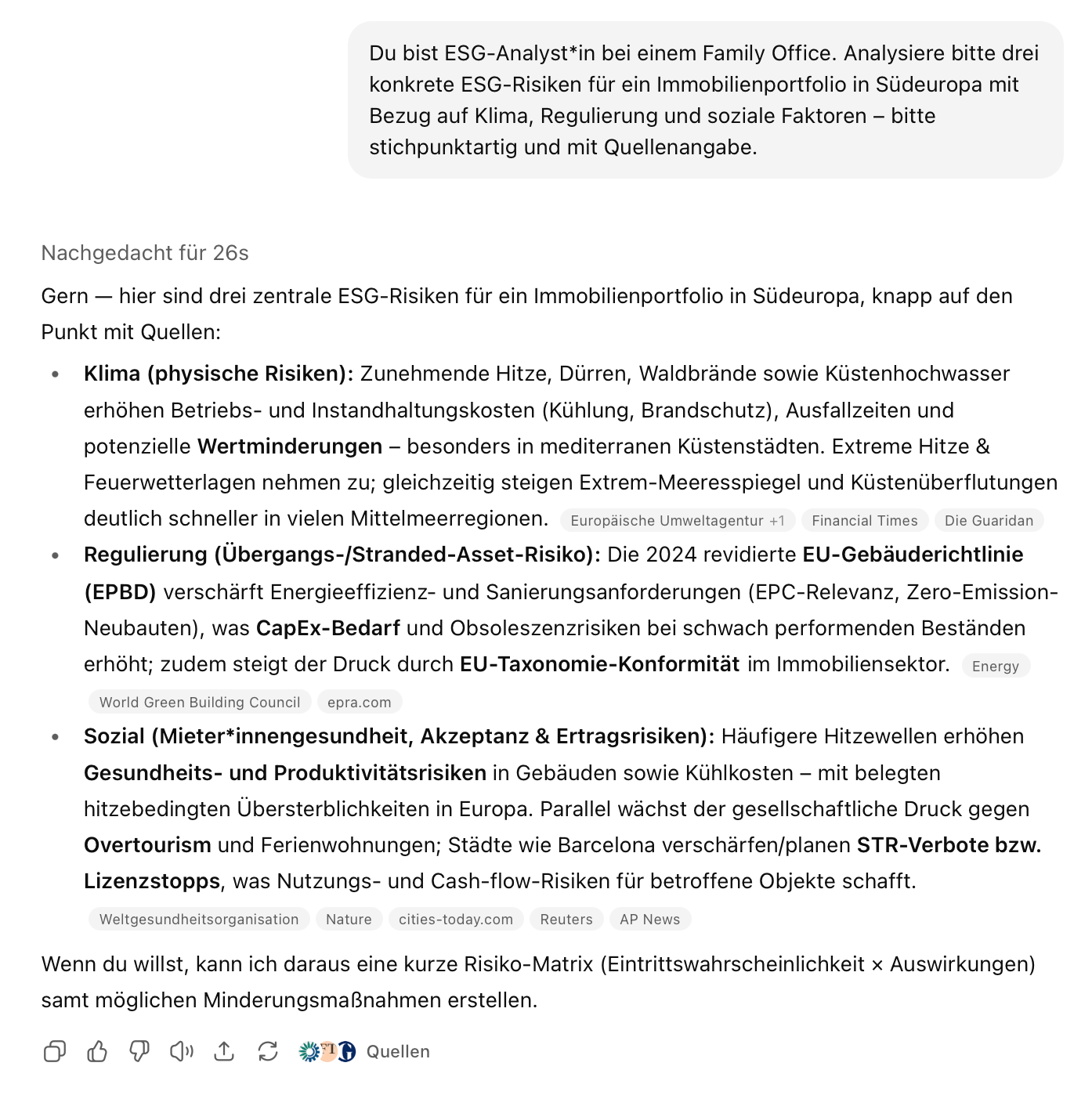

Prompt: „Du bist ESG-Analyst*in bei einem Family Office. Analysiere bitte drei konkrete ESG-Risiken für ein Immobilienportfolio in Südeuropa mit Bezug auf Klima, Regulierung und soziale Faktoren – bitte stichpunktartig und mit Quellenangabe.“

Antwort von ChatGPT:

Drei fundierte Punkte mit klarer Struktur, Quellenhinweisen und Handlungsansätzen:

Willkommen in der Welt des Promptings – dem entscheidenden Faktor für die Qualität von KI-Antworten. Inzwischen nutzen viele Tools wie ChatGPT, um Projekte zu strukturieren, Gesetze zu analysieren oder Texte zu formulieren. Doch die Qualität der Ergebnisse schwankt stark – von „beeindruckend präzise“ bis „juristisch haarsträubend“.

Woran liegt das? Die Antwort ist einfach – aber nicht banal: Es kommt auf die Eingabe an. Wer sich mit der Funktionsweise generativer KI beschäftigt, erkennt schnell: Ein „Prompt“ ist mehr als nur eine Frage. Er ist eine Technik – und mit der Zeit auch eine Fähigkeit. Prompting bedeutet, ein Modell präzise zu führen: mit Kontext, Struktur, Rollenvergabe und klarer Aufgabenstellung. Erst durch gute Prompts entfalten KI-Systeme ihr Potenzial – besonders in anspruchsvollen Feldern wie ESG oder Recht.

In diesem Artikel geben wir eine kompakte Hilfestellung:

📌 Welche Modelle gibt es, und worin unterscheiden sie sich?

📌 Wie formuliere ich bessere Prompts?

📌 Welche Tools eignen sich für ESG-Anwendungen – und wann macht Spezialisierung – wie bei ESGbot – Sinn?

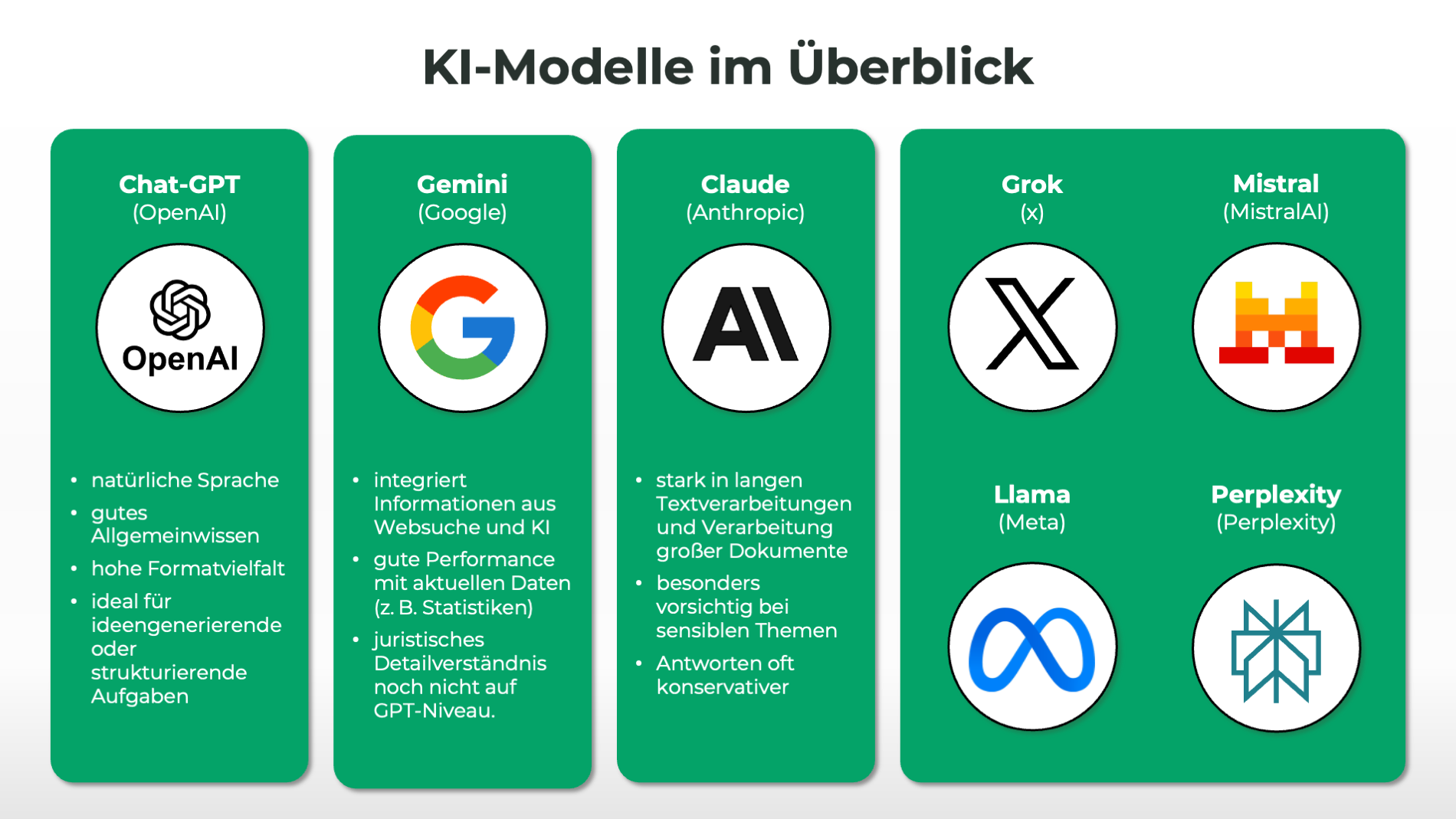

Überblick über KI-Modelle

Seit dem Durchbruch der generativen KI im Jahr 2022 ist eine Vielzahl leistungsstarker Sprachmodelle entstanden – jedes mit eigenen Stärken, Schwächen und Einsatzbereichen. Wer mit KI arbeitet, muss die Unterschiede kennen, um das passende Tool für die jeweilige Aufgabe auszuwählen. Denn: Nicht jedes Modell eignet sich für jede Fragestellung.

Architektur, Token und Trainingsdaten – was steckt drin?

Die heute führenden Sprachmodelle – wie GPT, Claude oder Gemini – basieren alle auf der Transformer-Architektur, die aufeinanderfolgende Texteinheiten – sog. Tokens – analysiert und auf Basis statistischer Wahrscheinlichkeiten fortschreibt.

Die Leistungsfähigkeit hängt dabei stark von drei Faktoren ab:

- Trainingsdaten: Je mehr und aktueller, desto besser.

- Modellarchitektur & Parameteranzahl: Je größer das Modell, desto potenziell leistungsfähiger – aber auch rechenintensiver.

- Tokenlänge: Je länger das Kontextfenster (z. B. 128k Tokens = ca. 350-400 „normale“ Seiten bei GPT-4), desto besser lassen sich auch komplexe Texte, Tabellen oder ganze Gesetzeswerke verarbeiten.

Sprachmodelle rechnen nicht nach Wörtern, sondern nach Tokens ab. Ein Token entspricht etwa einem Wortteil, ähnlich wie bei einer Silbe. Beispielsweise sind „Energie-“ und „-verbrauch“ zwei Tokens. Die meisten Anbieter (auch OpenAI) berechnen Input- und Output-Tokens getrennt nach Modell und nach Volumen. Je länger der Prompt und die Antwort, desto höher die Kosten. Präzise Prompts sparen daher nicht nur Zeit, sondern auch Budget.

Die wichtigsten Modelle im Überblick

GPT (OpenAI)

Die GPT-Modelle gelten als die bekanntesten Modelle. Sie überzeugen mit natürlicher Sprache, gutem Allgemeinwissen und hoher Formatvielfalt. Ideal für ideengenerierende oder strukturierende Aufgaben.

Claude (Anthropic)

Claude ist stark in langen Textverarbeitungen und besonders vorsichtig bei sensiblen Themen. Es verarbeitet große Dokumente und antwortet oft konservativer.

Gemini (Google)

Gemini integriert Informationen aus Websuche und KI. In Aufgaben mit aktuellen Daten oder Datenquellen (z. B. Statistiken) performt es gut, im juristischen Detailverständnis aber noch nicht auf GPT-Niveau.

Open-Source-Modelle (z.B. Mistral)

Technisch interessant für Unternehmen, die eigene KI-Anwendungen bauen möchten – mit vollem Zugriff auf Modellparameter. Fachlich aber weniger zuverlässig ohne gezieltes Nachtraining.

Darüber hinaus gibt es noch eine Vielzahl weitere Modelle wie z.B. Grok (X), LLaMA (Meta) oder Perplexity (Perplexity). Alle haben sich zum Ziel gesetzt das „beste Model“ an den Markt zu bringen – es bleibt spannend, wem das am Ende gelingen wird.

Methoden & Strukturen für bessere Prompts

Viele Nutzer*innen erwarten von KI, dass sie „einfach funktioniert“. Doch generative Modelle wie ChatGPT sind keine magischen Alleskönner – sie reagieren auf das, was man ihnen gibt. Prompting ist deshalb kein Nebendetail, sondern ein zentrales Steuerungsinstrument: Je klarer, strukturierter und zielgerichteter die Eingabe, desto brauchbarer die Antwort. Für fachspezifische Anforderungen zählen eben Präzision, Nachvollziehbarkeit und fachlicher Tiefgang.

Warum sind Prompts so entscheidend?

Sprachmodelle „verstehen“ keine Fragen im menschlichen Sinn – sie berechnen Wahrscheinlichkeiten für den nächsten passenden Textabschnitt auf Basis von Milliarden Mustern aus Trainingsdaten. Ohne Kontext wissen sie nicht, wie komplex die Antwort sein soll, für wen sie gedacht ist oder welches Format gewünscht ist. Prompting übersetzt Nutzerintentionen in maschinenlesbare Anweisungen.

Was oft schiefläuft – typische Fehler beim Prompting

Viele KI-Antworten sind nicht deshalb schlecht, weil das Modell versagt – sondern weil der Prompt zu vage, überladen oder unklar formuliert wurde. Die häufigsten Fehler sind:

- Unpräzise Fragen: „Wie geht ESG?“ führt zu einem oberflächlichen Ergebnis. Ohne Ziel oder Kontext kann die KI kaum sinnvoll priorisieren.

- Zuviel auf einmal: Wer in einem Prompt fünf Fragen stellt, bekommt meist auch fünf halbe Antworten – ohne Tiefe.

- Fehlender Rahmen: Ohne klare Rolle, Zielgruppe oder Formatvorgabe schreibt die KI ins Blaue.

Die gute Nachricht: Mit etwas Struktur lassen sich diese Probleme leicht vermeiden.

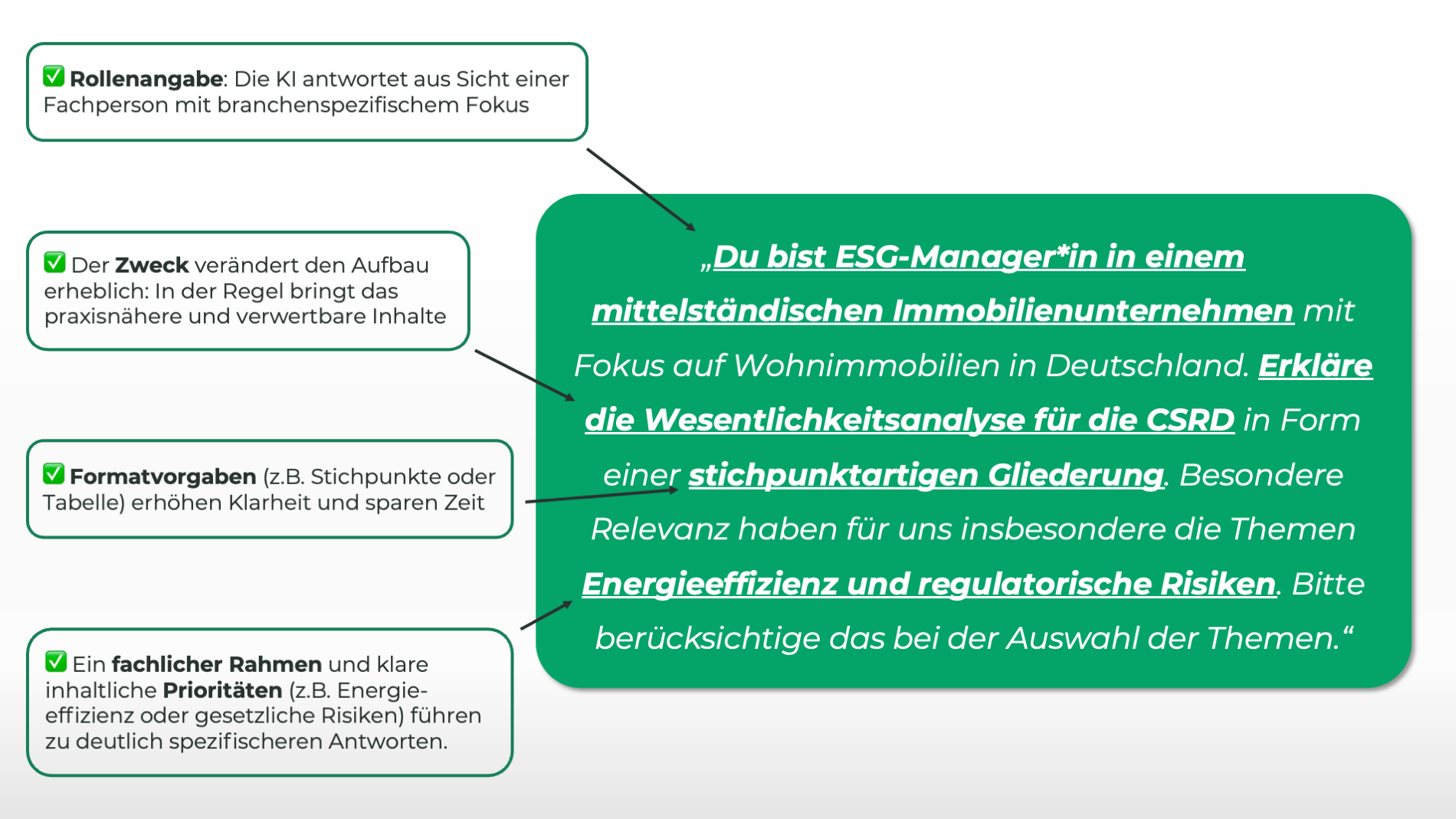

Der stufenweise Aufbau eines guten Prompts

Hier ein Beispiel, wie sich ein Prompt durch gezielte Ergänzungen deutlich verbessern lässt – mit konkretem Nutzen für den Output:

🔹 Schritt 1: Vage Anfrage

Prompt:

„Erkläre mir die Wesentlichkeitsanalyse.“

❗️ Allgemeine, wenig strukturierte Antwort mit Definition und Floskeln.

🔹 Schritt 2: Zielgruppe und Rolle definieren

Prompt:

„Du bist ESG-Manager*in in einem mittelständischen Immobilienunternehmen. Erkläre mir die Wesentlichkeitsanalyse.“

❗️Die Rollenangabe schärft die Perspektive: Die KI antwortet nun aus Sicht einer Fachperson mit branchenspezifischem Fokus – nicht mehr rein allgemein.

🔹 Schritt 3: Ziel der Antwort nennen

Prompt:

„Du bist ESG-Manager*in in einem mittelständischen Immobilienunternehmen. Erkläre die Wesentlichkeitsanalyse so, dass sie als Grundlage für einen Berichtsteil gemäß CSRD dienen kann.“

❗️Der Zweck verändert den Aufbauerheblich. Das Modell liefert nun praxisnähere und verwertbare Inhalte, zugeschnitten auf Berichtspflichten.

🔹 Schritt 4: Formatwunsch hinzufügen

Prompt:

„Du bist ESG-Manager*in in einem mittelständischen Immobilienunternehmen. Erkläre die Wesentlichkeitsanalyse so, dass sie als Grundlage für einen Berichtsteil gemäß CSRD dienen kann. Bitte in Form einer stichpunktartigen Gliederung.“

❗️Formatvorgaben wie Gliederung, Tabelle oder Pro-Contra-Struktur erhöhen Klarheit und sparen Zeit bei der Weiterverarbeitung – z. B. in Berichten oder Präsentationen.

🔹 Schritt 5: Rahmenbedingungen setzen

Prompt:

„Du bist ESG-Manager*in in einem mittelständischen Immobilienunternehmen mit Fokus auf Wohnimmobilien in Deutschland. Erkläre die Wesentlichkeitsanalyse für die CSRD in Form einer stichpunktartigen Gliederung. Besondere Relevanz haben für uns insbesondere die Themen Energieeffizienz und regulatorische Risiken. Bitte berücksichtige das bei der Auswahl der Themen.“

❗️Der Prompt enthält nun einen fachlichen Rahmen und klare inhaltliche Prioritäten – etwa Energieeffizienz oder gesetzliche Risiken im Wohnimmobilienbereich. Das führt zu deutlich spezifischeren, direkt verwertbaren Antworten für die Praxis.

Diese Art von Prompting macht aus einem allgemeinen Sprachmodell ein situationsangepasstes Fachtool – besonders hilfreich bei der Erstellung von Textbausteinen für Berichte, Vorlagen oder Schulungen.

Mit jeder Ergänzung wird der Prompt klarer, spezialisierter und nützlicher – und damit auch die Antwort. Prompting ist keine Zusatzfunktion, sondern eine der Grundlagen für alle seriösen KI-Anwendungen. Wer versteht, wie ein Modell „denkt“, kann es besser steuern – und so aus einer allgemeinen Textmaschine ein echtes Fachwerkzeug machen.

Allerdings: Für rechtsnahe oder datenbezogene Aufgaben reichen allgemeine Sprachfähigkeiten eines KI-Modells jedoch oftmals nicht aus.

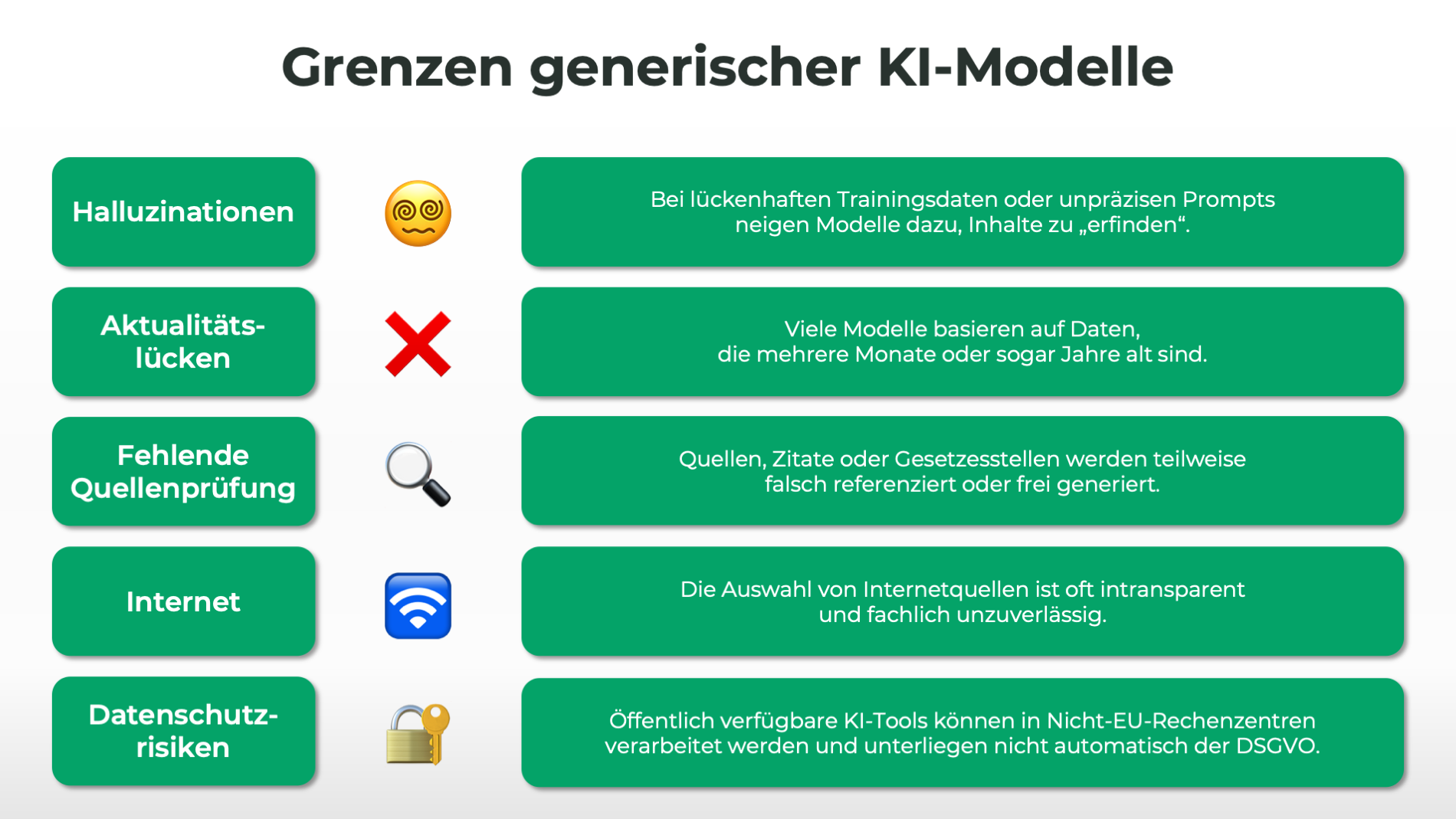

Grenzen generischer Modelle – und warum Spezialisierung zählt

So beeindruckend große Sprachmodelle mittlerweile sind – bei sachspezifischen Anforderungen (z.B. bei regulatorischen Themen zu ESG), stoßen sie schnell an ihre Grenzen. Der Grund: Die Modelle wurden auf breite Textmengen trainiert, aber nicht auf spezifische Rechtsvorgaben oder branchenspezifische Fachinhalte.

Typische Schwächen generischer Modelle:

- Halluzinationen: Bei lückenhaften Trainingsdaten oder unpräzisen Prompts neigen Modelle dazu, Inhalte zu „erfinden“. Das kann bei rechtlichen Aussagen gravierende Folgen haben.

- Aktualitätslücken: Viele Modelle basieren auf Daten, die mehrere Monate oder sogar Jahre alt sind. Neue Gesetzesfassungen, kürzlich delegierte Rechtsakte oder Berichtigungen fehlen oft.

- Fehlende Quellenprüfung: Modelle liefern Aussagen, aber keine belastbaren Belege. Zitate oder Gesetzesstellen werden teilweise falsch referenziert oder frei generiert.

- Internetrecherche als Unsicherheitsfaktor:

Einige KI-Modelle nutzen Webzugriff, um ihre Antworten mit aktuellen Informationen anzureichern. Erstens ist die Auswahl der Quellen oft intransparent und fachlich unzuverlässig. Zweitens ist unklar, ob personenbezogene oder sensible Daten datenschutzkonform verarbeitet werden. - Datenschutzrisiken: Eingaben in öffentlich verfügbare Tools wie ChatGPT Web können in Nicht-EU-Rechenzentren verarbeitet werden – und unterliegen nicht automatisch der DSGVO.

Gerade im ESG- oder Rechtskontext ist das problematisch: Wer Nachhaltigkeitsberichte schreibt, Rechtskataster pflegt oder regulatorische Pflichten prüfen will, braucht verlässliche, überprüfbare Informationen – keine textlich schönen Vermutungen.

KI-Tools im Einsatz: Was heute schon möglich ist

Nachdem wir jetzt wissen, wie ein guter Prompt geschrieben wird, schauen wir uns im nächsten Schritt ausgewählte KI-Tools zur alltäglichen Unterstützung an. Generative KI ist längst nicht mehr auf Chatbots beschränkt. Inzwischen gibt es eine Vielzahl spezialisierter Tools, die im Alltag unterstützen können. Auch wir bei ESGbot arbeiten mit einigen dieser Tools – mit klar definierten Einsatzfeldern und kritischem Blick auf ihre Grenzen.

🔹 ChatGPT (OpenAI)

Ideal für erste Analysen, Ideenfindung, Textentwürfe oder Formatierungen. Kommt bei uns z. B. beim Erstellen von diesem Blog-Artikel, Textbausteinen oder Strukturierung zum Einsatz. Schwächen zeigen sich bei Aktualität, Quellenlage und rechtlichen Details – weshalb wir hier nur auf die europäische API-Version mit kontrollierter Datenverarbeitung setzen.

🔹 tl;dv (Meeting-KI)

Wir testen tl;dv aktuell für interne und externe Meetings. Das Tool erstellt Transkripte, Highlights und automatisch verschlagwortete Zusammenfassungen. Besonders hilfreich, wenn Entscheidungen dokumentiert werden sollen.

🔹 Perplexity (Research-KI)

Nützlich für schnelle Recherchen, Faktenchecks und Quellenvergleiche – insbesondere bei der Quellensuche zu unseren Blog-Artikeln oder aktuellen Entwicklungen im Regulierungsumfeld. Die Kombination aus generativer Antwort und Quellenlink macht Perplexity zu einem produktiveren Assistenten als GPT für diesen Anwendungsfall, ersetzt aber keine juristische Prüfung.

🔹 DALL·E (Bild-KI)

Verwenden wir zur Erstellung von Grafiken für unsere Titelbilder oder LinkedIn-Beiträge.

Diese Tools helfen – aber sie ersetzen keine Fachanwendung. In diesem Bereich ist Spezialisierung entscheidend – gerade in ESG-nahen Anwendungsfeldern.

ESGbot als Beispiel für Spezialisierung

Ein solches spezialisiertes System ist der ESGbot. Die Plattform basiert auf einem generativen Sprachmodell (aktuell die neueste GPT-Version) und wurde gezielt auf ESG-, Energie- und Immobilienrecht zugeschnitten.

Nutzer*innen des ESGbot haben dabei einen entscheidenden Vorteil: Sie können ein Firmenprofil hinterlegen. So kann man für jede Anfrage an den ESGbot detaillierte Unternehmensinformationen in den Kontext einbetten – mit nur einem Klick! Das Firmenprofil ist zudem die Grundlage für alle weiteren KI-gestützten Schritte – wie z.B. die Erstellung eines VSME-Nachhaltigkeitsberichts.

Außerdem arbeitet der ESGbot, statt auf allgemeine Webinhalte zurückzugreifen, mit über 60 Gesetzen und technischen Standards – vollständig quellenbasiert, nachvollziehbar und stets aktuell.

Ein weiterer Vorteil: Die Verarbeitung erfolgt DSGVO-konform auf europäischen Servern. Für rechtlich sensible Themen im Unternehmenskontext ist das ein zentraler Aspekt.

Das Ergebnis:

Kontextsensitive Antworten, juristisch belastbare Quellen, weniger Nacharbeit – und mehr Vertrauen in KI-gestützte ESG-Prozesse.

Fazit und Ausblick

Gute Prompts sind kein Hexenwerk – aber sie folgen klaren Prinzipien. Wer die richtigen Rollen, Ziele und Formate vorgibt, erhält von generativen KI-Modellen deutlich bessere, präzisere und verlässlichere Antworten. Gerade im ESG-Kontext ist das entscheidend: Denn hier geht es nicht um kreative Wortspiele, sondern um regulatorische Sicherheit und inhaltliche Belastbarkeit.

Gleichzeitig gilt: Viele KI-Antworten scheitern nicht an der Technik, sondern am Menschen. Vage Fragen, zu viele Themen in einem Prompt oder fehlender Kontext führen oft zu schwachen Ergebnissen – obwohl das Modell mehr leisten könnte. Umso wichtiger ist es, sich mit dem Handwerk des Promptings vertraut zu machen und eine klare Struktur zu verfolgen.

Quellen

- Brown, T. B., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., Dhariwal, P., ... & Amodei, D. (2020). Language models are few-shot learners. arXiv. https://arxiv.org/abs/2005.14165

- OpenAI. (2023). Prompt engineering guide. https://platform.openai.com/docs/guides/prompting

- Zhou, C., Li, J., & Liu, G. (2023). A comprehensive survey on pretrained foundation models: a history from BERT to ChatGPT. arXiv. https://arxiv.org/abs/2302.09419

- Zhang, S., Dong, L., Li, X., & Wang, S. (2023). Instruction tuning for large language models: a survey. arXiv. https://arxiv.org/abs/2308.10792

- Google DeepMind. (2024, December 11). Introducing Gemini 2.0: our new AIodel for the agentic era. DeepMind blog. https://blog.google/technology/google-deepmind/google-gemini-ai-update-december-2024

- OpenAI. (2023). GPT-4 Technical Report. https://cdn.openai.com/papers/gpt-4.pdf

- Ji, Z., Lee, N., Frieske, R., Yu, T., Su, D., Xu, Y., ... & Fung, P. (2023). Survey of Hallucination in Natural Language Generation. ACM Computing Surveys, 55(12), 1–38. https://doi.org/10.1145/3571730